Avec ses deux co-auteurs, Malek Abbasi et Michel Théra, Sorin-Mihai Grad propose dans cet article de nouvelles méthodes pour étendre les méthodes d'optimisation au-delà des fonctions différentiables. En effet, l'une des étapes habituellement requises pour résoudre un problème d'optimisation est de trouver en quels points la dérivée de la fonction est égale à zéro (c'est la condition classique d'optimalité de Fermat), ce qui correspond à une pente nulle et donc à un maximum ou à un minimum (dans le cas des fonctions convexes).

Bien entendu, les choses se compliquent pour les fonctions non différentiables. Si une fonction est non dérivable et non convexe, il existe des résultats théoriques mais pas d'algorithmes généraux pour trouver les minimiseurs de ces fonctions. Dans la littérature, on trouve plusieurs notions de sous-différentiel, qui sont des objets mathématiques imitant le rôle de la dérivée pour les fonctions non différentiables, mais elles sont généralement difficiles à déterminer de manière itérative et, par conséquent, pratiquement impossibles à utiliser dans des algorithmes pratiques.

La solution décrite par Sorin-Mihai Grad et ses co-auteurs consiste à proposer un type de sous-différentielles partielles, qui ouvre la voie au développement d'algorithmes de minimisation de fonctions non différentiables et non convexes de plusieurs variables. Il s'agit du premier travail où les sous-différentielles partielles sont obtenues en décomposant une certaine sous-différentielle en composantes unidimensionnelles par le biais d'éléments de base et jouent le même rôle que les dérivées partielles dans les règles d'optimalité de Fermat.

Les fonctions ayant des variables unidimensionnelles étant plus faciles à manipuler, l'approche proposée dans ce travail devrait permettre de développer de nouveaux algorithmes pratiques pour minimiser les fonctions non convexes non différentiables, un type de fonctions qui apparaît souvent lors de la modélisation de diverses applications, par exemple dans l'apprentissage automatique et l'intelligence artificielle.

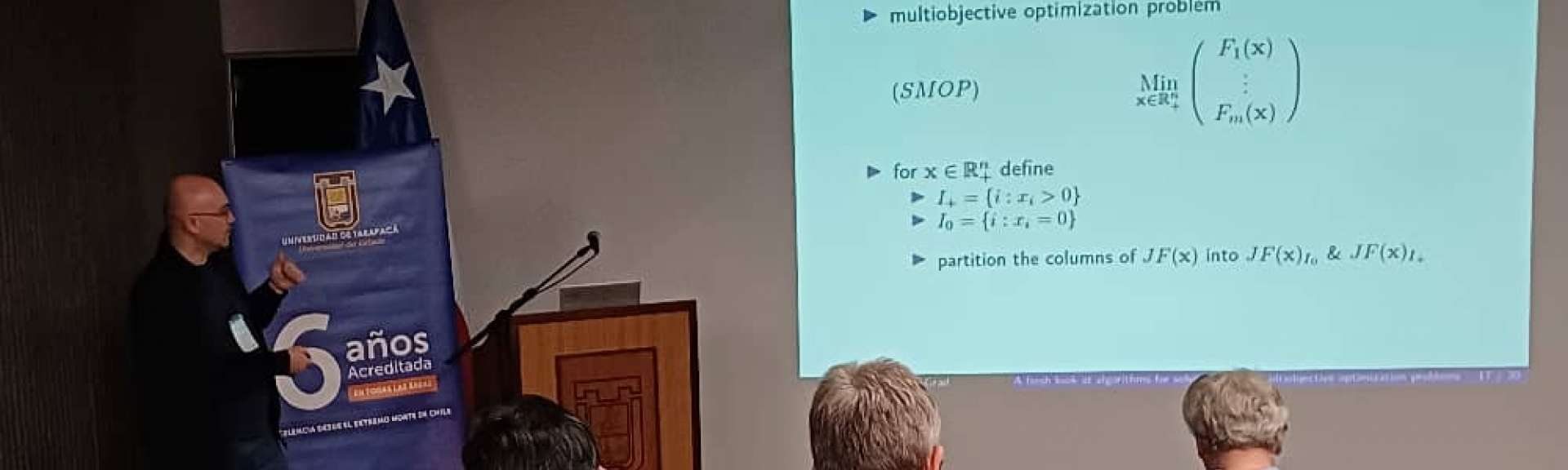

Sorin-Mihai Grad a également présenté ces résultats lors de plusieurs événements scientifiques, tels que la conférence SMAI-MODE de l'année dernière à Lyon, et le Workshop on Nonsmooth Optimization and Applications (NOPTA 2024) à Anvers, où il a présenté un exposé semi-plénier.