Les réseaux de neurones ont révolutionné l’approche de l’intelligence artificielle. Cantonnés initialement à des tâches répétitives de reconnaissance d’images ou de classement, ils remplissent aujourd’hui des fonctions de plus en plus complexes. Mais ils donnent des résultats certains, sans être capables de modéliser les limites de leurs connaissances. Ce genre de résultats peut s’avérer dangereux dans le monde très incertain qui est le nôtre, comme l’explique Gianni Franchi, enseignant-chercheur d'ENSTA Paris :

« Prenons le cas d’un réseau de neurones entraîné à reconnaître des animaux : chats, chiens, oiseaux, il est imbattable. Mais il ne sait faire que ça. Si jamais on lui présente une image de voiture, il y a de fortes chances pour qu’il dise que c’est un chien, car c’est l’espèce qui a la plus grande variabilité morphologique intrinsèque. Pour le réseau, la voiture sera un nouveau type de chien, avec des pattes rondes ! Et lorsqu’on lui demandera la confiance qu’il accorde à ce classement, il donnera un score de 90% !

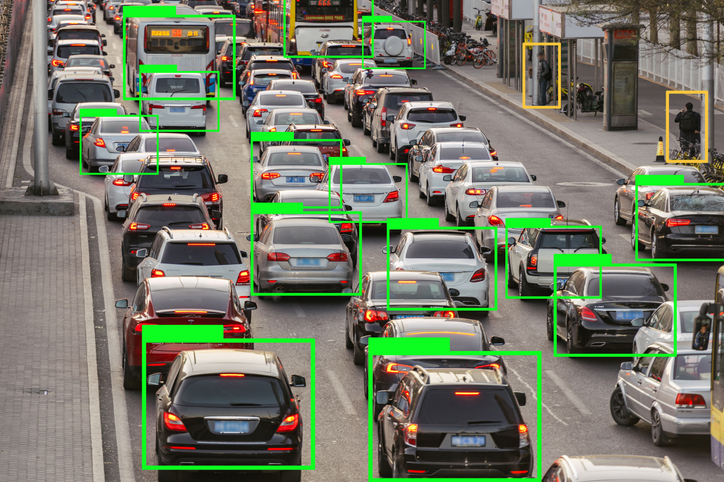

Imaginez à présent la situation inverse : un autre réseau de neurones entraîné à reconnaître des panneaux routiers, des voitures et des obstacles courants, et installé à bord d’un véhicule autonome. Surgit un sanglier au détour d’une route de campagne, une classe d’objet qu’il n’a jamais vue. Le risque est grand qu’il ne l’interprète ni comme un arbre, ni comme un piéton, et laisse le véhicule poursuivre son chemin vers cet objet qui n’entre pas dans ses catégories, et n’existe donc pas pour lui. »

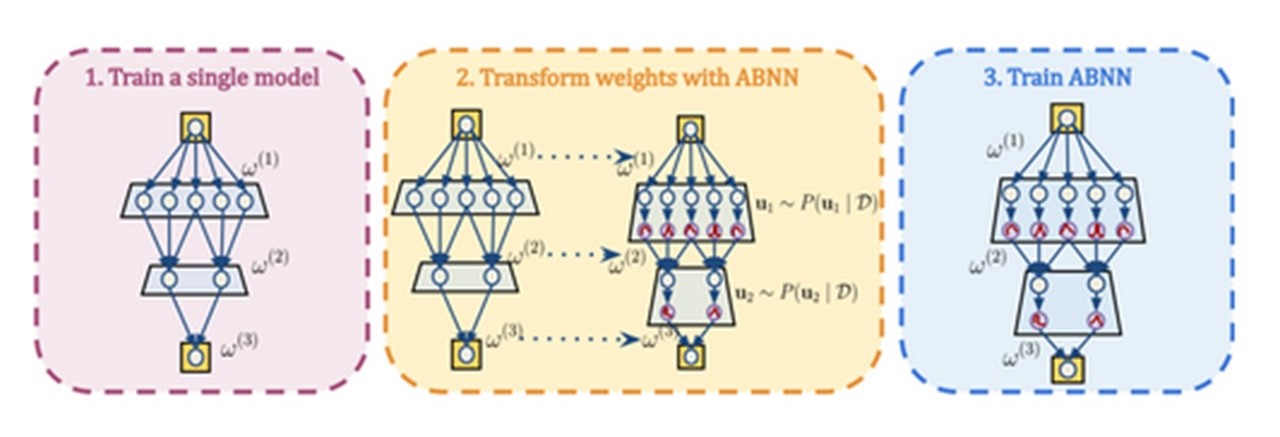

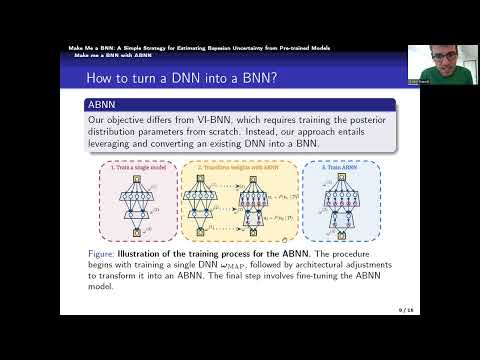

Les réseaux de neurones bayésiens ont une distribution au niveau de chaque neurone qui leur permet de gérer ce type d’incertitude. La nouvelle approche que Gianni Franchi détaillera à Seattle, permet de transformer un réseau de neurones classique en réseau de neurones bayésiens sachant gérer l’incertitude. Cette technique permet de réutiliser tous les réseaux neurones déjà entrainés à faire des taches complexes comme GPT, ou autres, ce qui permet d’économiser temps et énergie.

Références : Make me a BNN : a simple strategy for estimating Bayesian Uncertainty from pre-trainded Models. Gianni Franchi (U2IS,ENSTA Paris), Olivier Laurent (ENSTA Paris, Université Paris-Saclay), Maxence Leguery (U2IS, ENSTA Paris), Andrei Bursuc (Valeo IA), Andrea Pilzer (NVIDIA) & Angela Yao (NUS)